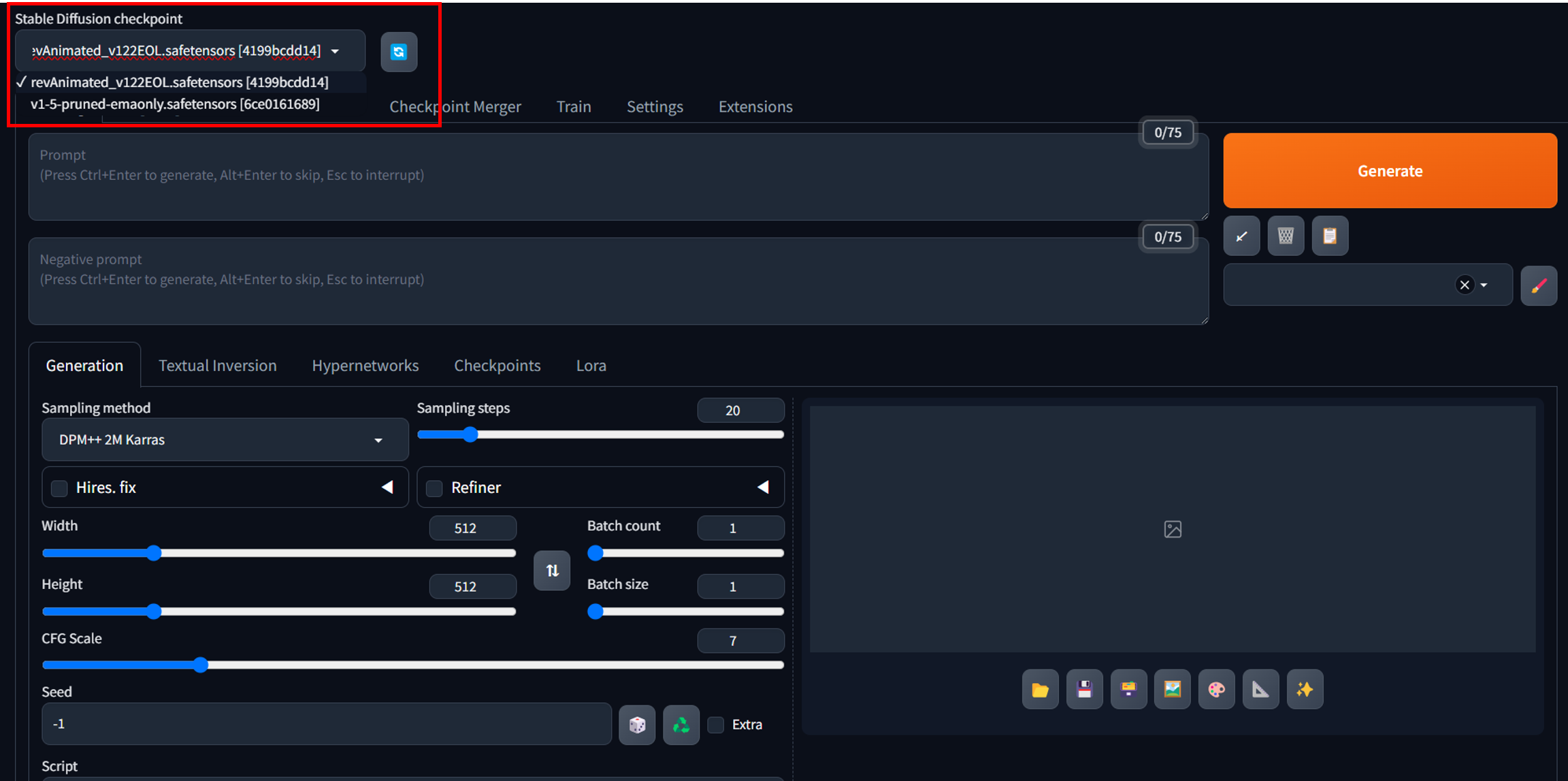

여러 checkpoint 사용해보기

Civitai: The Home of Open-Source Generative AI

Explore thousands of high-quality Stable Diffusion models, share your AI-generated art, and engage with a vibrant community of creators

civitai.com

위의 웹사이트에서 'rev animated' checkpoint를 다운받는다.

강사님 말씀으로는 상당히 많은 train image로 학습시켜서 나온 checkpoint로 고성능의 결과를 볼 수 있다고 한다.

다운로드 받은 .safetensors 파일을 [C:\Users\user\stable-diffusion-webui\models\Stable-diffusion] 해당 경로안에 넣어주면 위와 같은 checkpoint list에 추가된다.

이제 Image promting을 실제로 해보자.

예시로 나온 사진을 그대로 똑같이 프롬프팅하여 결과 사진을 확인해 보자. 우측 하단에 i 를 누르면 프롬프트 sample이 나온다.

앞서 우리가 anaconda 환경에서 실행한 창에 동일하게 입력하면, 정확히 동일한 이미지는 나오지 않지만 매우 유사한 그림을 얻을 수 있다.

[Prompt]

(digital painting),(best quality), serene Japanese garden, cherry blossoms in full bloom, koi pond, footbridge, pagoda, Ukiyo-e art style, Hokusai inspiration, Deviant Art popular, 8k ultra-realistic, pastel color scheme, soft lighting, golden hour, tranquil atmosphere, landscape orientation

()는 강조하는 단어 표시, 너무 중복되는 단어가 있다면 성능이 저하된다고 한다.

[Text to Image]

예시로 사람의 모습을 만들고 싶다고 한다면, 우리가 프롬프트에 하나한씩 앉아있는지, 어디에 앉았는지, 다리는 어떤지, 팔은 어떤지 등등..의 수많은 단어들을 입력해야 된다. 이러한 경우를 위해서 Openpose로 분석하여 사람의 동작을 인식하여 그 동작을 직접적으로 프롬프팅 할 수 있는 Extension 기능을 설치할 수 있다.

URL for extension's git repo 입력란 안에 'https://github.com/Mikubill/sd-webui-controlnet'을 입력한다.

설치가 완료되면, [Installed]에서 'Apply and restart UI'를 선택한다.

완료되면 위와 같이 이미지를 끌어 놓을 수 있는 공간이 새롭게 생긴다.

아직 끝나지 않았다. OpenPose로 해당 이미지를 분석할 수 있는 MLP 모델이 필요하다.

https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main

lllyasviel/ControlNet-v1-1 at main

Detected Pickle imports (3) "collections.OrderedDict", "torch.FloatStorage", "torch._utils._rebuild_tensor_v2" What is a pickle import?

huggingface.co

.pth 파일 중

'control_v11p_sd15_openpose.pth'

'control_v11p_sd15_depth.pth',

'control_v11p_sd15_canny_pth'

'control_v11p_sd15_lineart.pth'

'control_v11p_sd15_seg.pth'

'control_v11p_sd15_softedge.pth'

모두 다운로드 받고 [C:\Users\user\stable-diffusion-webui\extensions\sd-webui-controlnet\models] 디렉토리 안에 넣어준다.

원하는 동작의 그림을 찾아서 입력하면(왼쪽 사진), OpenPose로 분석하여 프롬프트에서 해당 행동 좌표를 참조한다.

+) 계속 사람의 얼굴이 뚜렷하지 않거나, 폭력, 선정성 사진이 만들어진다면?

걸러낼 단어, 장면에 대한 filter 역할을 해줄 embedding 모델을 다운로드한다.

{Civitai} 에서 검색 가능

1. [Easy Negative] : https://civitai.com/models/7808/easynegative

2. [7 Dirty Words negative prompt] : https://civitai.com/models/15287?modelVersionId=18009

다운로드 후, [C:\Users\user\stable-diffusion-webui\embeddings] 디렉터리 안에 넣기!

+) 얼굴 보정 설정하기

메뉴 'Setting' -> 좌측 메뉴 중 Postprocessing 'Face restoration' -> 첫 번째 체크박스 확인! ->

상단 주황색 Apply settings 클릭

메타코드M

빅데이터 , AI 강의 플랫폼 & IT 현직자 모임 플랫폼ㅣ메타코드 커뮤니티 일원이 되시기 바랍니다.

mcode.co.kr

'배우기 > AI prompt 배우기' 카테고리의 다른 글

| [AI 프롬프트] 메타코드 강의 6일차_동영상 생성하기 (0) | 2024.03.27 |

|---|---|

| [AI 프롬프트] 메타코드 강의 5일차_DreamBooth 모델 & Lola 모델 (0) | 2024.03.26 |

| [AI 프롬프트] 메타코드 강의 4일차_Image to Image, Inpaint (0) | 2024.03.24 |

| [AI 프롬프트] 메타코드 강의 2일차_Stable_Diffusion 설치 및 활용 (0) | 2024.03.21 |

| [AI 프롬프트] 메타코드 강의 1일차_오리엔테이션&생성 AI 사례 (0) | 2024.03.18 |